Il faut bien prendre des risques ![]()

Olivier Blanchard X post

A fun exercise.

Since the beginning of the year:

S&P500 has increased from 5800 to 6600. Yields on 10y treasuries have decreased from 4.6% to 4.1%. Gold prices have increased from 2600 to 3700. An unusual combination.

All three are forward looking. What is the news that would explain all three?

A guess: A combination of higher expected potential growth, maybe due to AI, which would explain the stock price increase, and increased uncertainty, partly due again to AI, partly due to Trump, which would explain lower safe rates and a shift to gold.

Alternative interpretations?

Je n’aime pas quand Blanchard se pose des questions, car il m’a l’air extraordinairement fûté.

Nous risquons de vivre des temps… intéressants.

Un rapport de Apollo research rapporté sur X par KoyfinCharts.

- The weight of the MagnificenSeven* more than 30% of the S&P 500, about level with prior peaks in mid-2024 and early-2025.

Nvidia, the largest stock in the index, has a P/E of 51x.

2) The weight of Technology, Media, and Telecoms in the S&P 500 (almost 45%) is sitting at levels last seen in the 1999-2000 bubble.

3)

Measures of concentration in the S&P 500 are at record high levels, as per the Herfindahl-Hirschman Index (HHI).

The HHI measures how concentrated the index is in its constituent companies. Higher = less diversified.

-

The performance of tech index relative to S&P 500 higher than tech bubble.

-

Both the S&P 500 and Nasdaq 100 are reaching new highs while the percentage of index members reaching new highs is low. Fewer companies are accounting for a larger share of the momentum.

The spread between best & worst performing sectors is the lowest in decades.

- Earnings expectations are rising for large caps (S&P 500) but flat for small caps (Russell 2000).

Actual earnings are rising for large caps, and falling for small caps.

- The S&P 500 price to sales ratio is the highest it has been in decades, surpassing the levels in the 1999-2000 tech bubble.

P/E data shows relative overvaluation too.

- The capital expenditure share of GDP much higher for hyperscalers today vs telecom companies during dot-com bubble.

Analyse intéressante :

Un article intéressant envoyé par @thomas.moyse :

Résumé généré avec un LLM:

Contexte & objectif

- L’innovation est aujourd’hui un levier indispensable pour les organisations face à des environnements en rapide mutation.

- L’article s’inscrit dans une démarche de retour d’expérience R&D (au sein d’OCTO) fondée sur une expérimentation (avec ChatGPT-4o) dans le cadre d’un projet labellisé Crédit Impôt Recherche (CIR).

- Il vise à explorer le potentiel créatif de l’IA générative — et ses limites — lorsqu’elle est utilisée pour soutenir la génération d’idées (idéation).

Points clés & enseignements

1. La créativité humaine : entre émergence et évaluation métacognitive

- La créativité est définie comme la capacité à produire des idées à la fois nouvelles et appropriées (selon les critères du contexte).

- Une part non triviale du processus créatif humain consiste non seulement à générer des idées, mais aussi à évaluer ses propres idées — ce processus métacognitif aide à sélectionner ou rejeter des pistes (et à éviter l’effet de fixation).

- Cette capacité d’auto-jugement est cruciale pour éviter de rester bloqué sur des idées médiocres ou peu audacieuses.

2. IA générative : outil ou acteur créatif ?

- Les IA génératives (comme ChatGPT) sont de plus en plus mobilisées par les organisations pour stimuler la créativité.

- Mais ici se pose une question : l’IA génère-t-elle de la créativité réelle, ou reproduit-elle des combinaisons de ce qu’elle a appris, de façon rapide et statistique ?

- Peu d’études comparent de manière systématique les processus de créativité humaine avec ceux des modèles d’IA.

3. Résultats de l’expérimentation & observations

L’article rapporte des observations issues de l’expérimentation. Voici quelques enseignements marquants :

- Avantages de l’IA générative dans l’idéation

• L’IA peut générer rapidement un grand nombre d’idées (diversité quantitative), ce qui peut “débloquer” l’inspiration.

• Elle peut fournir des pistes inhabituelles ou des associations inattendues que l’humain n’aurait pas spontanément explorées.- Limites et précautions à considérer

• L’IA est sujette à ses propres biais algorithmiques : elle reproduit les stéréotypes ou les tendances présentes dans ses données d’apprentissage.

• Du côté humain, divers biais cognitifs entrent en jeu :

– Biais d’automatisation : tendre à faire confiance à ce que propose l’IA, sans le remettre en question.

– Biais d’ancrage : la première réponse générée par l’IA peut devenir une “idée de référence” et limiter l’exploration d’autres alternatives.

– Biais de confirmation : orienter les requêtes pour obtenir ce que l’on pense déjà, et valider ce qui confirme nos intuitions.

• Le jugement humain reste indispensable pour filtrer, critiquer et enrichir les idées issues de l’IA. L’IA n’est pas une “boîte noire magique”.

• Il est préférable d’alterner les phases avec et sans IA, pour conserver la liberté de pensée et éviter une forme de “paresse intellectuelle”.

• L’expérimentation met en lumière la nécessité d’adopter une posture de co-création (interaction active) plutôt que de simple « édition passive » des suggestions de l’IA.4. Impacts organisationnels & enjeux humains

- L’adoption de l’IA générative ne se limite pas à intégrer un outil : elle invite à repenser les processus de gouvernance, les flux de travail et les rôles dans les équipes.

- De nouveaux métiers (comme “prompt engineer”) émergent, de même que des compétences transversales autour de la pensée critique, de la conscience des biais et de la méthodologie itérative.

- L’IA ne remplace pas le jugement humain mais l’augmente (si bien encadrée) — elle peut libérer les humains des tâches routinières pour qu’ils se concentrent sur les choix à forte valeur ajoutée.

En conclusion

L’article d’OCTO montre que l’IA générative apporte un appui puissant à l’innovation, en fournissant une source rapide et abondante d’idées. Mais « puissance » ne rime pas avec « parfait » : les biais algorithmiques, les biais cognitifs humains et l’absence de jugement émergent comme des obstacles réels.

L’enjeu consiste donc à concevoir une coopération raisonnée entre humain et machine :

- exploiter la capacité de l’IA à générer des propositions vastes et surprenantes,

- garder un rôle actif dans le filtrage, le tri, l’itération et l’appropriation des idées,

- structurer les processus pour éviter que l’IA (et ses suggestions) ne devienne un “conduit passif” sans critique,

- sensibiliser aux biais (algorithmiques et cognitifs) pour maintenir la diversité et la qualité des idées.

Définitivement révolution. Quand vous voyez la vitesse à laquelle ça progresse.

Des chercheurs de Stanford ont lancé Paper2Agent, un système d’IA multi-agents qui transforme automatiquement les articles de recherche en agents d’IA interactifs avec une intervention humaine minimale.

Paper: [2509.06917] Paper2Agent: Reimagining Research Papers As Interactive and Reliable AI Agents

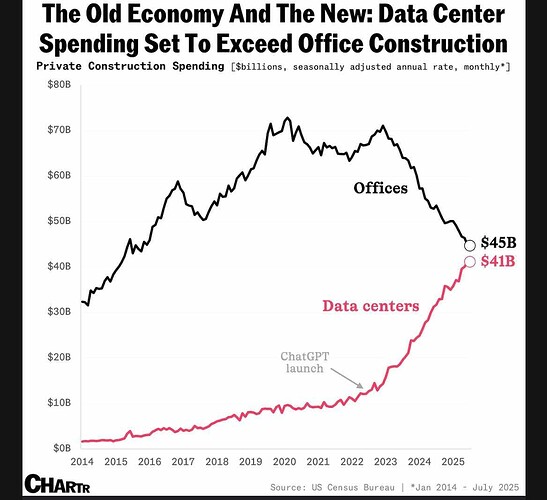

La bataille de la capacité de calcul disponible :

Vidéo de l’évolution du graphique sur X

« ![]() US vs

US vs ![]() China numbers here are unbelievable.

China numbers here are unbelievable.

The US controls the absolute majority of known AI training compute on this planet and continues to build the biggest, most power hungry clusters.

China is spending heavily to close the gap. Recent reporting pegs 2025 AI capital expenditure in China at up to $98B, up 48% from 2024, with about $56B from government programs and about $24B from major internet firms. Capacity will grow, but translating capex into competitive training compute takes time, especially under export controls.

With US controls constraining access to top Nvidia and AMD parts, Chinese firms are leaning more on domestic accelerators. Huawei plans mass shipments of the Ascend 910C in 2025, a two-die package built from 910B chips. US officials argue domestic output is limited this year, and Chinese buyers still weigh tradeoffs in performance, memory, and software.

![]() Chips and policy are moving targets

Chips and policy are moving targets

The policy environment shifted again this week.

A new US arrangement now lets Nvidia and AMD resume limited AI chip sales to China in exchange for a 15% revenue share paid to the US government, covering products like Nvidia H20 and AMD MI308.

This could boost near-term Chinese access to mid-tier training parts, yet it does not restore availability of the top US chips.

Beijing is cautious about reliance on these parts. Chinese regulators have urged companies to pause H20 purchases pending review, and local media describe official pressure to prefer domestic chips.

![]() Why performance still favors the US stack like NVIDIA

Why performance still favors the US stack like NVIDIA

Independent analysts compare Nvidia’s export-grade H20 with Huawei’s Ascend 910B and find the Nvidia part still holds advantages in memory capacity and bandwidth, which matter for training large models.

But software maturity gaps around Huawei’s stack remains, that reduce effective throughput, even when nominal specs look close to older Nvidia parts like A100.

These issues make it harder for Chinese labs to match US training runs at the same wall-clock cost. »

Une nuance sur cette information largement relayée, apportée par une source chez Accenture :

Mouais en fait 12000 c’est environ 1,5% de la masse salariale donc c’est nos départs naturels non remplacés sur les postes où l’IA va changer la nature, les process etc, mais c’est pas un plan de licenciement

Note de synthèse du Shift Project (facile à lire) :

Intelligence artificielle, données, calculs : quelles infrastructures dans un monde décarboné ?

C’est plus que le programme Apollo ![]()

Thinking Machines Lab est une entreprise de recherche/produits IA fondée en février 2025 par Mira Murati (CTO chez OpenAI). L’équipe a recruté ~30 personnes venant d’OpenAI, Meta, Mistral, etc.

Financial Times

The hundreds of billions of dollars companies are investing in AI now account for an astonishing 40 per cent share of US GDP growth this year. And some analysts believe that estimate doesn’t fully capture the AI spend, so the real share could be even higher.

AI companies have accounted for 80 per cent of the gains in US stocks so far in 2025. That is helping to fund and drive US growth, as the AI-driven stock market draws in money from all over the world, and feeds a boom in consumer spending by the rich.

Since the wealthiest 10 per cent of the population own 85 per cent of US stocks, they enjoy the largest wealth effect when they go up. Little wonder then that the latest data shows America’s consumer economy rests largely on spending by the wealthy. The top 10 per cent of earners account for half of consumer spending, the highest share on record since the data begins.

But without all the excitement around AI, the US economy might be stalling out, given the multiple threats.

Je pense fondamentalement que AI aura le même impact qu internet. Comme internet on risque l éclatement d une bulle. Des qu un de ces deals circulaires va exploser pour x raisons les investisseurs vont avoir peur comme en 2000. La moindre mauvaise nouvelle d importance, par example Oracle se dedit sur son backlog de projets, une reduction des besoins de puces NV DIA grâce à un nouveau modèle moins gourmand en cpu mais plus performant, etc entraînera une chute du marché . Mais Sur le LT si vous investissez pourles 20 prochaines années vous amortirez sans casse. AI est là pour durer avec des effets transformationels considérables.

Une comparaison intéressante :

The lesson from shale is not that success evaporates. It is that success does not guarantee profits for all. There will be returns in AI; but only for those who sit inside the envelope now being constructed around it.

On en a déjà parlé dans d’autres sujets, par exemple sur les véhicules électriques, l’aérien, l’automobile, les panneaux solaires etc. Ce n’est pas parce qu’une technologie est largement adoptée que cela se transforme en gains pour les investisseurs de la catégorie.

Il devient de plus en évident que OpenAI est à la bulle AI ce qu etait Lehman Brothers à la crise des subprimes en 2008.

FT:

Ces accords donneraient à OpenAI accès à plus de 20 gigawatts de capacité de calcul, soit environ l’équivalent de la puissance de 20 réacteurs nucléaires, au cours de la prochaine décennie.

Selon les estimations des dirigeants d’OpenAI, chaque GW de capacité de calcul d’IA coûte environ 50 milliards de dollars à déployer aux prix actuels, soit un coût total d’environ 1 000 milliards de dollars.

"OpenAI n’est pas en mesure de prendre aucun de ces engagements », a déclaré Gil Luria, analyste chez DA Davidson, qui a ajouté qu’il pourrait perdre environ 10 milliards de dollars cette année.

Je n’ai aucune idée de si les valorisations des boites autour de l’IA sont justifiables ou non, par contre en termes de révolution j’en suis de plus en plus convaincu, la dernière news qui m’a bluffé concerne les olympiades de mathématiques.

Les olympiades sont des épreuves internationales pour des élèves particulièrement brillants dans différentes disciplines (dont les math donc), ne serait-ce qu’une participation aux olympiades est une réussite dingue, je vous laisse regarder les CV des gens présents dans cette liste. Pour résumer chaque pays fait concourir les 6 meilleurs représentants de son pays dans chaque discipline. Évidemment les problèmes posés aux olympiades sont nouveaux pour éviter tout risque de triche et particulièrement difficiles puisque posé aux meilleurs des meilleurs.

Donc, la dernière news qui m’a scié concerne les résultats de différents modèles aux olympiades de math, par exemple Google annonce avoir obtenu une médaille d’or : Advanced version of Gemini with Deep Think officially achieves gold-medal standard at the International Mathematical Olympiad - Google DeepMind

Grosso modo : elles se classeraient dans le très (très) haut du panier, sur des problèmes nouveaux et le tout dans des conditions qui sembleraient identiques à celles des participants. Les solutions proposées sont ici : https://storage.googleapis.com/deepmind-media/gemini/IMO_2025.pdf (je n’y comprends absolument rien, mais des gens brillants ont jugé cela correct ![]() )

)